Hoeveel megabytes in een gigabyte?

Veel gebruikers zijn niet te veel tegengekomeneen aangename situatie: u koopt een harde schijf met een volume, bijvoorbeeld 500 gigabytes, verbindt het met een computer en merkt dat er ongeveer 480 gigabytes beschikbaar zijn. En dat allemaal omdat fabrikanten van harde schijven geloven dat de gigabyte 1000 megabytes is, en Windows OS zeker is dat 1024. Wie heeft gelijk? Hoeveel megabytes in een gigabyte?

Veel gebruikers zijn niet te veel tegengekomeneen aangename situatie: u koopt een harde schijf met een volume, bijvoorbeeld 500 gigabytes, verbindt het met een computer en merkt dat er ongeveer 480 gigabytes beschikbaar zijn. En dat allemaal omdat fabrikanten van harde schijven geloven dat de gigabyte 1000 megabytes is, en Windows OS zeker is dat 1024. Wie heeft gelijk? Hoeveel megabytes in een gigabyte? De grootste moeilijkheid is dat De hoeveelheid informatie kan worden gemeten in zowel binaire als decimale systemen. Daarnaast zijn er verschillende normen van eenheden voor het meten van de hoeveelheid informatie. Dit veroorzaakt verwarring en maakt het moeilijk om precies te bepalen hoeveel megabytes er in een gigabyte zitten.

In feite, voorvoegsels "kilo", "mega", "giga-" enzovoort worden gebruikt in het internationale systeem van eenheden (SI) en duiden de bevoegdheden van het getal tien aan. Daarom, als je logisch denkt, zou er in één gigabyte 1000 megabytes moeten zijn. Maar waarom is uw besturingssysteem zeker dat er 1024 zijn?

Het feit is dat ontwikkelaars van veel moderne besturingssystemen gebruiken het standaard geheugen JEDEC 100B.01 (de standaard van de Joint Engineering Council voorelektronische apparaten), volgens welke de voorvoegsels die in het SI-systeem worden geaccepteerd, niet een macht van tien kunnen aangeven, maar een macht van twee (dat wil zeggen, de standaard gebruikt niet een decimaal getalsysteem, maar een binair getal). Daarom is een gigabyte van de standaard JEDEC gelijk aan 1024 megabytes.

En fabrikanten van harde schijven en flash-drives gebruiken Normen aangenomen door de International Electrotechnical Commission (IEC). Volgens deze normen worden SI-voorvoegsels gebruikt om graden van het getal tien aan te geven. Daarom zou één gigabyte 1000 megabytes moeten zijn en niet meer megabytes. GOST 8.417-2002, die de namen van meeteenheden op het grondgebied van Rusland regelt, houdt zich ook aan dit gezichtspunt.

Als het belangrijk is om te benadrukken dat we het hebben over een binair getalsysteem, Het is noodzakelijk om geen decimale consoles te gebruiken, maar binair (binair). In dit geval zullen 1024 bytes gelijk zijn aan één kibibyte, 1024 kibibytes aan één mebibyte, 1024 mebibytes aan één gibi-byte. Het zijn deze binaire bijlagen die zijn overgenomen in de IEC-standaard.

Het probleem is dat binaire bijlagen, hoewel ze correct zijn, maar praktisch niet worden gebruikt. Ten eerste, historisch gezien, bleek datdecimale consoles worden gebruikt om de eenheden van de hoeveelheid informatie in het binaire systeem aan te duiden. Ten tweede zijn binaire consoles gewoon niet erg euphonious.

Het is dus onwaarschijnlijk dat een gewone gebruiker zal tegenkomenmeeteenheid "gibibyte", omdat bijna niemand het gebruikt. En hoe kan hij bepalen hoeveel megabytes in een gigabyte in dit geval 1000 of 1024 zijn? Er moet aandacht aan worden besteed een eenheid schrijven voor het meten van de hoeveelheid informatie.

Volgens het voorstel van de IEC, als een binaire kilobyte / megabyte / gigabyte wordt gesuggereerd, moet de notatie beginnen met een hoofdletterbijvoorbeeld GB, Gbyte, GB. Deze aanduiding geeft aan dat de gigabyte in dit geval 1024 megabytes is. Als de eerste letter in de notatie een kleine letter is (gbyte, gbyte, gb), bedoelen we een decimale ("commerciële") gigabyte, bestaande uit 1000 megabytes.

Zoals u kunt zien, bij de aanduiding van meeteenheden voor het informatievolume, decimale SI-voorvoegsels, die ook worden gebruikt in die gevallen waarin de IEC-standaard binaire prefixen moet gebruiken. Daarom is het in gigabyte 1000 en vervolgens 1024 megabytes.

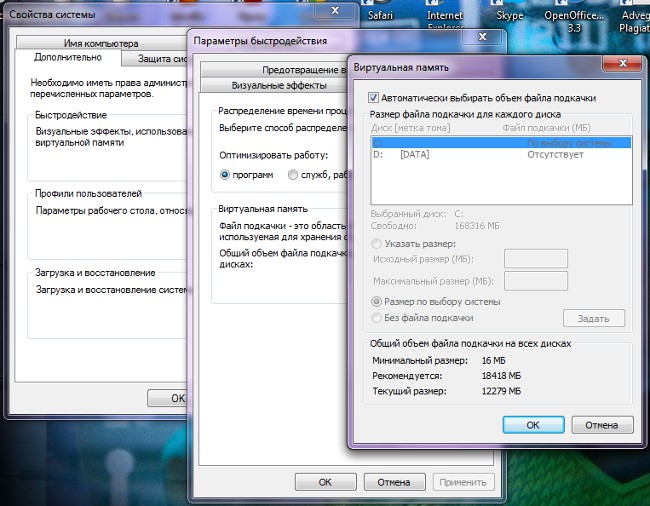

Het is het gemakkelijkst om dat te onthouden fabrikanten van harde schijven en flash drives gebruiken "correcte" gigabytes, decimaal. En de fabrikanten van RAM,videogeheugen, cd's, maar ook Microsoft en Apple (respectievelijk ontwikkelaars van OS Windows en Mac OS X) en softwareontwikkelaars gebruiken binaire gigabytes die 1024 megabytes bevatten (wat het correct zou zijn om gibibytes en mebibytes te noemen).